将Robots.txt完美应用在网站优化 为什么Robots.txt十分重要?

为什么Robots.txt十分重要?

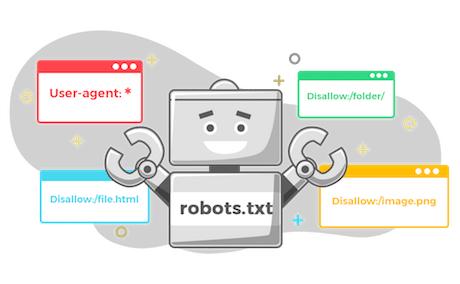

robots.txt也称为排除协议或标準,是一份用于告诉搜寻引擎抓取网站上哪些页面的文本文件。假设搜寻引擎即将访问某网站,在访问目标页面前,它将检查robots.txt中的说明,并对每个页面进行爬虫。在检索错误之前,Googlebot会尝试抓取robots.txt文件,只是为了查看网站上是否有不希望被索引的区域。

但当网页繁杂,搜寻引擎需要一段时间进行爬虫,这可能会对排名产生负面影响,由于Google搜寻引擎机器人有一定的「爬虫预算」,主要取决于爬虫速度与爬虫需求,也就是要让搜寻引擎认定某页面有价值,并愿意採取行动。

如何应用在网站中???????Robots.txt

如果您想快速查看robots.txt文件,在此分享一种超级简单的查看方法。实际上,此方法适用于任何网站,因此,您可藉机浏览其他网站文件并查看其运行状况。

首先在浏览器搜寻栏中输入网站的基本网址,然后将/robots.txt添加至末端。接着将发生以下三种情况之一:

您会找到一个robots.txt文件您会发现一个空白文件您会得到404错误文件

当发现空白文件或404文件,则需进行修复。若找到有效文件,则可能为当时创建网站时的内建设置。在无robots.txt文件的情况下,可使用纯文本编辑器来创建新的robots.txt文件:

首先先设置user-agent term。进行设置后,则可适用于所有网络机器人在上述文字后键入星号(*)来执行动作接下来,输入“ Disallow:”,但后面切勿输入任何内容。由于无任何内容接续,此将引导网络机器人对整个网站进行爬虫功能应用

如何优化robots.txt取决于网站内容,有各种方法可使用robots.txt发挥优势。

robots.txt文件的最佳用途之一是告诉搜寻引擎不要抓取网站中未公开显示的部分,从而最大程度地提高并不浪费爬虫预算。另外,也可使用类似指令来防止抓取特定页面,例如以下几种页面类型是建议考虑从索引中排除:

有目的的重複性内容:某些重複内容在少数情况下是必要且可被接受的,但需排除相对不重要的複本被抓取感谢页面:透过屏蔽感谢页面,可确保只有经过既定程序的潜在客户才可造访该页面。禁止索引页面:使用noindex指令,与disallow指令配合使用,确保搜寻引擎不会访问某些禁止页面或将其编入索引,使该页面不会显示在SERP中禁止追蹤指令:nofollow实际上与nofollow连接相同,旨在告诉网络机器人不要抓取页面上的连接进行测试

测试robots.txt文件,主要是确保所有内容均有效并以正确的方式运行。Google于网站管理员工具中提供免费的robots.txt测试器。若创建成功,则会发现搜索範围增加。

结语

透过SEO公司,正确设置robots.txt文件动作,不仅可增强SEO,实践结构化资料,还可提升使用者体验。当搜寻引擎机器人能明智花费爬虫预算,则会以最佳方式整理并在SERP中显示内容,提升网页能见度。

另外设置robots.txt文件无需花费太多精力,主要是一次性设置,并根据需要进行修改。因此无论您拥有几个网站,使用robots.txt都会产生很大的不同,若您还从未尝试,建议不妨立即试试看!

声明本文内容来自网络,若涉及侵权,请联系我们删除! 投稿需知:请以word形式发送至邮箱18067275213@163.com

即将为人父,也是我即将面临的事一路顺利~~~

没有注意过有这种情况哦。呵呵,可能因为我没在意,所以就被百度和google正常收录了吧。

外部链接建设,早晚会被淘汰掉,以后只有优质的内容与良好网站架构的站点才可以生存下去(黑帽手法链接建设除外)个人观点。

期待上市 ~~~~

《S.E.O》

碰到过,写的不错

新年快乐

落伍文化真是无处不在啊…..站长加油吧

期待,一会去淘宝看看有卖没,不知道要多少钱啊,嘿嘿

不错,我们刚成立seo公司,似乎看清了方向了。