robots.txt是一个简单的文本文件,位于网站的根目录下,用于告知搜索引擎爬虫(如谷歌、百度等)哪些页面或文件可以被爬取,哪些不可以。它使用了Robots Exclusion Standard(机器人排除标准)协议,是一种自愿遵守的网页爬取规范。 robots.txt的结构及语法

robots.txt的结构及语法

robots.txt文件主要包含两个部分:User-agent(用户代理)和Disallow(禁止)。

User-agent:用于指定该规则适用于哪些搜索引擎爬虫。可以使用通配符*表示所有的爬虫。

Disallow:指定不允许爬取的文件或目录。路径相对于根目录,以斜杠/开头。如果没有指定Disallow,表示允许爬取所有页面。

此外,可以使用Allow指令来明确允许爬取某些文件或目录。另外,还可以使用#符号来添加注释。

robots.txt使用示例

下面是一些常见的robots.txt文件示例:

允许所有搜索引擎爬虫访问所有页面:

makefile 代码

User-agent: *

Disallow:

禁止所有搜索引擎爬虫访问所有页面:

makefile 代码

User-agent: *

Disallow: /

禁止特定搜索引擎爬虫访问所有页面(如禁止Googlebot):

makefile 代码

User-agent: baidubot

Disallow: /

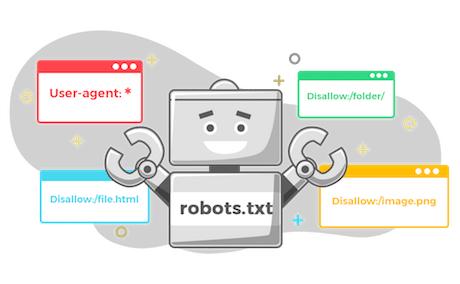

禁止所有搜索引擎爬虫访问特定目录(如禁止访问/admin/目录):

javascript 代码

User-agent: *

Disallow: /admin/

禁止所有搜索引擎爬虫访问特定文件(如禁止访问example.html文件):

makefile 代码

User-agent: *

Disallow: /example.html

注意事项

robots.txt文件必须位于网站的根目录下,并以小写命名。

请确保文件的语法正确,否则搜索引擎爬虫可能会忽略它。

使用Disallow指令时要小心,以免意外地阻止搜索引擎爬虫访问重要页面。

请注意,robots.txt协议是自愿遵守的,恶意爬虫可能会忽略它。因此,对于确保网站安全和保护敏感数据,应采用其他安全措施,如密码保护或IP限制等。

可以使用/sitemap.xml或/sitemap_index.xml为搜索引擎提供网站地图。

关于robots.txt文件,还可以补充以下几点: Sitemap:在robots.txt文件中,可以使用Sitemap指令来提供网站的Sitemap(站点地图)位置。Sitemap可以帮助搜索引擎更有效地发现和索引网站内容。示例如下:

Sitemap:在robots.txt文件中,可以使用Sitemap指令来提供网站的Sitemap(站点地图)位置。Sitemap可以帮助搜索引擎更有效地发现和索引网站内容。示例如下:

makefile

代码

User-agent: *

Disallow:

Sitemap: https://www.example.com/sitemap.xml

多个User-agent:如果需要为不同的搜索引擎爬虫设置不同的规则,可以在robots.txt文件中包含多个User-agent部分。例如:

javascript 代码

User-agent: Googlebot

Disallow: /private/

User-agent: Bingbot

Disallow: /private/

Disallow: /archive/

模糊匹配:Disallow和Allow指令支持使用*作为通配符进行模糊匹配。例如,禁止所有搜索引擎访问所有以private开头的目录:

makefile 代码

User-agent: *

Disallow: /*private*/

延迟爬取:可以通过Crawl-delay指令来要求搜索引擎爬虫在连续请求之间等待一定的时间。这有助于减轻服务器负担。但请注意,并非所有搜索引擎都支持此指令。示例如下:

makefile 代码

User-agent: *

Crawl-delay: 10

测试robots.txt文件:很多搜索引擎提供了在线测试工具,以检查robots.txt文件的语法和功能。例如,百度站长平台,Google Search Console等搜索引擎管理后台中的"robots.txt测试工具"可以帮助检查搜索引擎爬虫对特定URL的访问权限。

请注意robots.txt文件虽然对搜索引擎优化(SEO优化)和网站内容管理有一定作用,但它并不能确保信息安全。对于确保网站安全和保护敏感数据,请采用其他安全措施,如HTTPS、访问控制、防火墙等。

声明本文内容来自网络,若涉及侵权,请联系我们删除! 投稿需知:请以word形式发送至邮箱18067275213@163.com

英文名叫SEO in action,中文就叫SEO在行动或者SEO进行中。可能翻译不到位吧,参考原来struts in action的名字

好象很早的帖了 ““`

Pinging chinamyhosting.com [203.175.160.101] with 32 bytes of data:Reply from 203.175.160.101: bytes=32 time=466ms TTL=49Reply from 203.175.160.101: bytes=32 time=328ms TTL=49Reply from 203.175.160.101: bytes=32 time=322ms TTL=49Reply from 203.175.160.101: bytes=32 time=313ms TTL=49Ping statistics for 203.175.160.101: Packets: Sent = 4, Received = 4, Lost = 0 (0% loss),Approximate round trip times in milli-seconds: Minimum = 313ms, Maximum = 466ms, Average = 357ms

我想问一下,文中的图片是用什么软件处理的?可以告诉我吗?谢谢!

分析的不错,谢谢分享。看来google比百度更客观一些。